Analyse textuelle, Data visualisation et Data Storytelling : comment faire parler des données non structurées ?

Les commentaires libres, questions ouvertes, articles de presse, tweets, corpus de textes et autres discours, sont riches d’une matière qu’il est difficile à appréhender autrement que par la lecture et la compréhension du sujet. Les marques et les organisations sont pourtant amenées, avec l’explosion du web social notamment, à s’y intéresser pour parvenir à maîtriser les sujets abordés et idées émises au sein de ces contenus, afin de tenter à terme de les réguler, voire de les orienter pour faciliter l'aide à la décision.

Comment alors passer d’une matière textuelle riche et sans structure apparente, sujet à interprétation et à polémique, à des indicateurs clairs et lisibles ? Comment rationnaliser la lecture, sans pour autant perdre l’expérience de l’immersion au sein de la matière brute des textes d’origine ?

Pour répondre à cette problématique, nous avons développé des méthodes et des logiciels permettant de marier l’analyse textuelle et sémantique. Ceci permet de comprendre le sens du texte et de réduire le volume d’information en produisant infographies et data visualisations. En restituant l’essence des données et en engageant le lecteur dans un processus interactif et immersif, l’analyse de données débouche sur le storytelling.

L’analyse sémantique, pour catégoriser les contenus

Grâce à l’utilisation de thésaurus (arbre de connaissance regroupant les contenus selon leurs champs lexicaux), nous sommes capables d’identifier automatiquement les thématiques abordées dans les commentaires des individus et de les regrouper par idées générales ou concepts plus détaillés. Cette première approche offre l’avantage de limiter les a priori liés à l’expérience et la sensibilité du lecteur, en se basant sur une approche objective pilotée par les univers lexicaux et organisée selon le modèle du thésaurus.

Ainsi dans une étude sur les posts émis par les étudiants de Science Po sur les réseaux sociaux (accédez aux résultats), nous pouvons remarquer que la grande majorité des éléments sont communiqués via des photos, qu’ils portent sur l’intimité (corps nu et vie de couple) et la vie festive étudiante (soirées, amis, drogues, …).

La classification pour définir des typologies de discours

En mobilisant les méthodes de classification, nous cherchons à regrouper les individus les plus proches, selon les proximités lexicales et/ou sémantiques de leurs contenus. Cela nous permet de réduire fortement le volume d’informations et d’identifier des personae, représentatifs de comportements types. Ainsi, dans l’étude portant sur les motivations des Gilets jaunes à soutenir leur mouvement (article paru dans Le Monde, édition du 27 janvier 2019), l'analyse de contenu fait émerger 4 classes, portées par les éléments liés à la Crise du politique, le Pouvoir vivre (dignement), la Soif de justice et Le mouvement populaire. Cette réduction à 4 classes pourra être ensuite associée à des éléments de contexte (situation géographique, catégorie socio-professionnelle, revenus, …) pour mieux les expliquer et les illustrer.

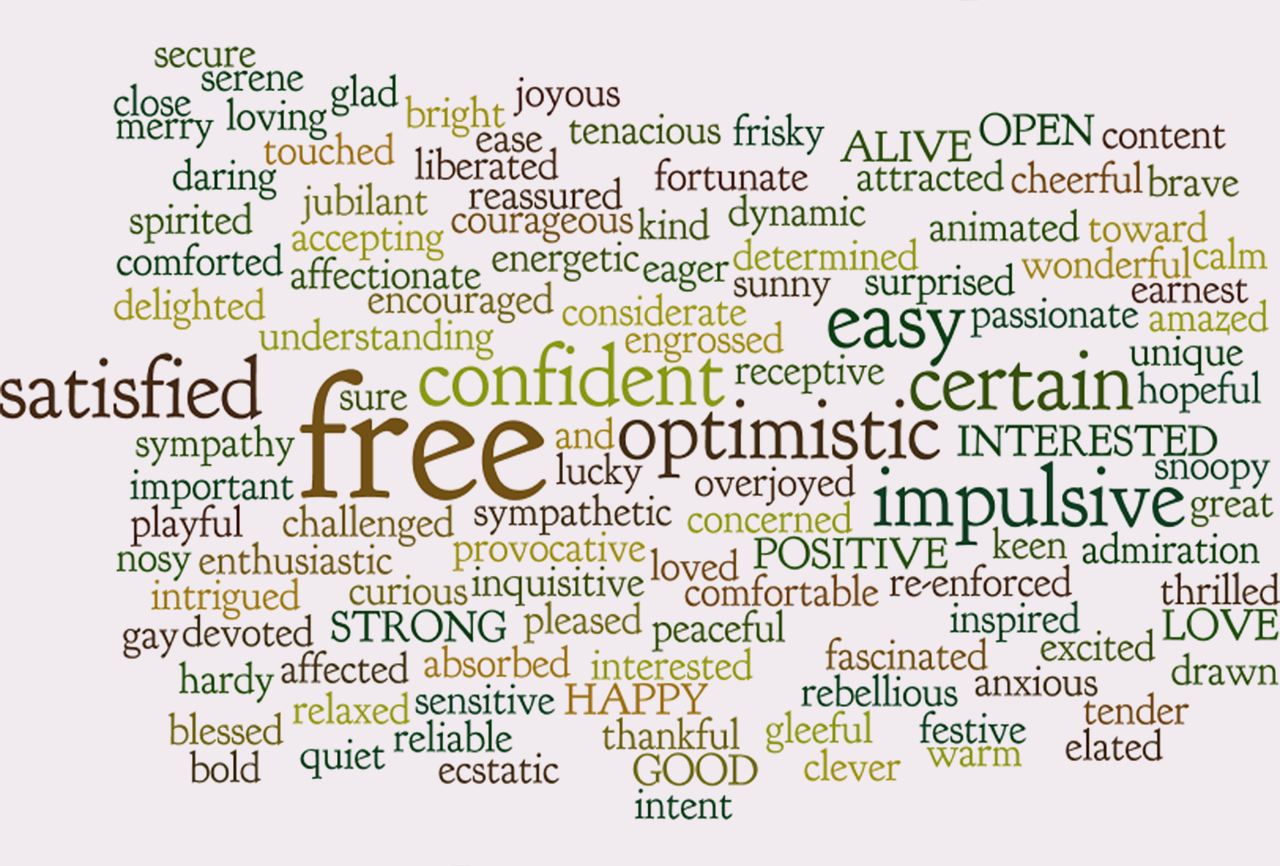

Les nuages d’expressions pour s’immerger dans les contenus

La classification ou l’analyse sémantique a le mérite de réduire le niveau d’information pour gagner en lisibilité, mais elle peut être parfois trop éloignée du mode d’expression pour permettre de s’imprégner pleinement de « l’ambiance » et du climat des commentaires. Les regroupements lexicaux, lorsqu’ils sont effectués au niveau des expressions (suite de mots consécutifs) offrent un concentré du mode de communication des individus s’exprimant, tout en donnant un premier niveau de synthèse. Représentés sous forme de nuages de mots lemmatisés et interactifs, dont la taille dépend du nombre d'occurrences, ces verbatim « réduits » ou éléments de langage spontanés se présentent alors comme un moyen de voyager et de s’immerger dans les commentaires, en offrant une alternative efficace à la fouille et à la lecture exhaustive des verbatim. Dans l’analyse des commentaires des Gilets Jaunes, on pourra ainsi retrouver « Le pouvoir au peuple », « l’augmentation des salaires » ou encore « le ras le bol général », qui sonnent comme des échos de la révolte et donnent un peu plus le ton exprimé par ce mouvement (accédez aux résultats).

De la data visualisation au data storytelling

La multiplication des indicateurs et représentations graphiques est très tentante dès lors que les contenus textuels ont été structurés. L’usage de l’interactivité permet de vivre une véritable expérience de lecture et de navigation. Cliquer, filtrer, illustrer, qu’il est bon de jouer avec les données ! Toutefois, sans histoire, la visualisation peut-être perçue comme une BD pleine de bulles vides. Difficile dès lors de s’accrocher à un scénario pour garder le fil de l’histoire. Voilà pourquoi nous évoluons naturellement de la data visualisation vers le data storytelling : construire des scénarii de lecture avec une intrigue, des acteurs et des décors.

L’analyse des 32 000 tweets de Trump, par sa variété et son abondance nous a poussés à cet exercice : mobiliser texte, image et scénarisation pour raconter au lecteur l’histoire des 140 caractères du petit oiseau (accédez aux résultats).

Un monde des possibles pour qui le veut

Des données non-structurées et illisibles, à une histoire intrigante dont le lecteur peut être le héros, il n’y a donc qu’un pas. Le plus dur sera sans doute d’avoir l’imagination de l’auteur et la rigueur du scientifique. Pour le reste, c’est-à-dire les algorithmes et l’intelligence logicielle pour traiter les données mais aussi produire des tableaux de bord, la technologie nous les offre et elle s’appelle DATAVIV' by Sphinx. Pour en savoir plus sur cette solution SaaS spécialiste de l'analyse quantitative et qualitative, ainsi que dans la visualisation des données, c'est par ici !

Inscrivez-vous pour tester DATAVIV' !

Essai gratuit pendant 15 jours

Utilisez vos propres données